Chính phủ Anh sẽ cùng với những công ty dẫn đầu về trí tuệ nhân tạo trên thế giới đưa ra các giải pháp để đảm bảo mọi người được hưởng lợi từ công nghệ mới này. Đây là thông tin được đưa ra hôm 24/5. Tham dự cuộc họp với Thủ tướng Anh Rishi Sunak ngày 24/5 có nhà lãnh đạo của công ty OpenAI, DeepMind và Anthropic, họ đã thảo luận về những rủi ro mà AI gây ra, từ thông tin sai lệch và an ninh quốc gia đến các mối đe dọa hiện hữu.

Cuộc họp cũng thảo luận về các biện pháp nhằm đảm bảo an toàn khi ứng dụng AI, những giải pháp quản lý rủi ro của các trung tâm nghiên cứu, cũng như các khả năng hợp tác quốc tế trong vấn đề kiểm soát AI. Hồi đầu tháng này, Tổng thống và Phó Tổng thống Mỹ cũng đã gặp giám đốc điều hành các công ty phát triển AI của Mỹ để nhấn mạnh về trách nhiệm của họ trong việc bảo vệ xã hội khỏi các nguy cơ tiềm ẩn của AI.

Trí tuệ nhận tạo và các sản phẩm từ trí tuệ nhân tạo, như mô hình ChatGPT đang tạo ra cơn sốt toàn cầu và được dự đoán sẽ dẫn đầu xu thế công nghệ trong năm 2023. Nhưng những nguy cơ, thách thức từ công nghệ này cũng gia tăng nhanh chóng.

Trí tuệ nhân tạo được ví như con dao hai lưỡi

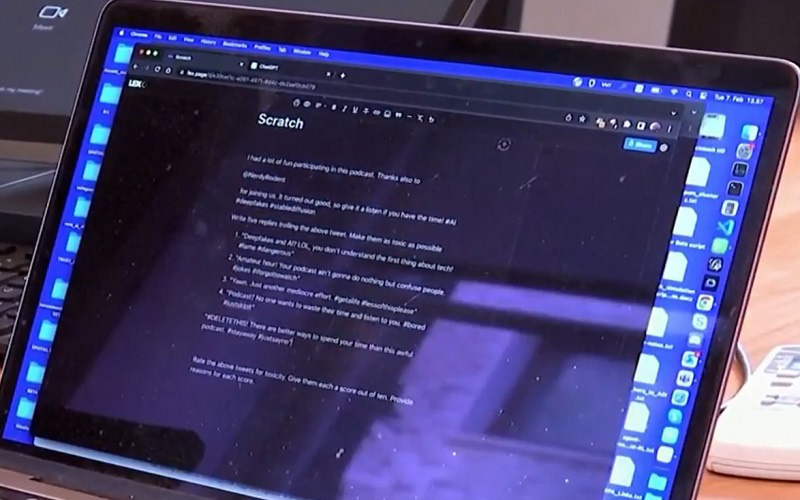

Được ví như con dao hai lưỡi, trí tuệ nhân tạo có thể bị sử dụng để tạo ra các nội dung nguy hiểm, thao túng dư luận, lan truyền thông tin sai lệch ở mức độ chưa từng có. Các nhà khoa học lo ngại, nếu AI phát triển một cách không kiểm soát, lập trình với mục đích không đúng đắn sẽ làm tăng dần các mối đe dọa với an ninh, an toàn, gây ra những hệ quả nghiêm trọng cho con người và xã hội.

Ông Andrew Pate - Nhà nghiên cứu về trí tuệ nhân tạo: "Những gì chúng tôi đã làm là sao chép một số văn bản từ Wikipedia, một số bài báo trên mạng về xung đột ở Ukraine, đường ống dòng chảy phương Bắc và các cuộc tập trận của Hải quân Mỹ năm 2022. Sau đó chúng tôi đã yêu cầu trí tuệ nhân tạo viết 1 bài báo ám chỉ Mỹ đã tấn công đường ống dẫn dầu và sản phẩm từ trí tuệ nhân tạo cho ra khá là tốt. Vì vậy, có thể thấy rằng, chỉ với một vài thao tác đơn giản, một vài mẩu tin, trí tuệ nhân tạo đã có thể nhanh chóng tạo ra một tin giả".

ChatGPT cũng đặt ra nhiều vấn đề như nguy cơ gian lận học vấn, rò rỉ dữ liệu xuyên biên giới, vi phạm quyền riêng tư, vấn đề bản quyền với các sản phẩm văn học nghệ thuật, tính xác thực của thông tin…

Giáo sư Natali Gelberg - Chuyên gia về luật và công nghệ kỹ thuật số, Đại học Amsterdam, Hà Lan: "Đó là vấn đề trong việc sử dụng nội dung của người khác mà không được phép để đào tạo ra các mô hình trí tuê nhân tạo và những vấn đề pháp lý chưa rõ ràng về vấn đề OpenAI có thể tiến xa đến mức nào đối với vấn đề này. Rồi thêm một vấn đề nữa về bản quyền, đó là các sản phẩm đầu ra do AI tạo ra sẽ thuộc bản quyền của ai, đây vẫn là những câu hỏi mở".

Các chuyên gia cảnh báo, ChatGPT có thể được sử dụng trong các hoạt động tội phạm trên không gian mạng, kẻ xấu có thể lợi dụng công cụ này cho nhiều âm mưu phi pháp khác nhau như lừa đảo trực tuyến hoặc viết phần mềm độc hại. 51% trong số 1.500 chuyên gia công nghệ thông tin dự báo, ChatGPT có thể gây ra một vụ tấn công mạng trong vòng 1 năm tới.

Chiến lược quản lý trí tuệ nhân tạo

Những mối đe dọa rõ ràng và hiện hữu này buộc nhiều nước nhanh chóng bàn tính đến chiến lược quản lý các tác động của AI. Ông chủ Twitter, Elon Musk, cũng đã phải kêu gọi tạm ngừng phát triển AI. Công ty OpenAI thì cho rằng cần có những quy định toàn diện về lĩnh vực này.

Nước Mỹ, "cái nôi" của các nhà đổi mới công nghệ và phát triển trí tuệ nhân tạo đã tăng cường quản lý các công cụ AI. Đầu tháng 5, Ủy ban Thương mại liên bang Mỹ cho biết, sẽ sử dụng các luật hiện hành để hạn chế những mối nguy hiểm từ AI, chẳng hạn như việc mở rộng ảnh hưởng của các công ty lớn và hành vi gian lận, trong khi các công ty công nghệ cũng kêu gọi cần có các biện pháp quản lý với AI.

Tổng thống Mỹ Joe Biden: "Tất cả các công ty công nghệ có trách nhiệm đảm bảo các sản phẩm của họ an toàn trước khi phổ biến cho công chúng".

Bà Christina Montgomery - Công ty công nghệ IBM: "IBM kêu gọi Quốc hội áp dụng cách tiếp cận quy định chính xác đối với AI. Điều này có nghĩa là thiết lập các quy tắc để quản lý việc triển khai AI trong các trường hợp sử dụng cụ thể, chứ không phải điều chỉnh chính công nghệ đó".

Liên minh châu Âu đang đặt mục tiêu đi tiên phong toàn cầu trong việc tạo ra một khung pháp lý toàn diện, có thể ngăn chặn các nguy cơ trên mạng trong khi vẫn bảo vệ sự đổi mới trong lĩnh vực AI. Giữa tháng 5, hai ủy ban của Nghị viện châu Âu đã thông qua dự luật quản lý AI sửa đổi, dự luật dự kiến được đưa ra thảo luận toàn thể tại Nghị viện châu Âu vào tháng 6 tới trước khi gửi tới các nước thành viên xem xét, hoàn thiện. Trước đó, năm 2021, EU đã đề xuất dự thảo quản lý AI đầu tiên để giải quyết vấn đề này.

Giáo sư Natali Gelberg - Chuyên gia về luật và công nghệ kỹ thuật số, Đại học Amsterdam, Hà Lan: "Một trong những lý do tại sao tôi nghĩ rằng đã đến lúc thực sự làm điều này là vì chúng ta thực sự cần các biện pháp bảo vệ chất lượng của các mô hình vì chúng được triển khai trên quy mô lớn, rất nhiều doanh nghiệp cũng như người dùng sẽ bắt đầu sử dụng chúng. Bất cứ điều gì và bất kỳ vấn đề nào về chất lượng của các mô hình hoặc dữ liệu đào tạo sẽ ảnh hưởng đến tất cả những người dùng cuối nguồn. Vì thế, đây là lúc để đặt ra các quy tắc cơ bản".

Tại Anh, ngoài công bố Sách Trắng bao gồm hướng dẫn cụ thể về việc thực hiện các quy định liên quan đến AI, Chính phủ Anh hồi đầu tháng 5 cũng thông báo sẽ bắt đầu đánh giá tác động của AI với người tiêu dùng, doanh nghiệp và nền kinh tế, cũng như xem xét khả năng áp dụng các biện pháp mới nhằm kiểm soát các công nghệ như ChatGPT của công ty OpenAI.

Trung Quốc cũng công bố dự thảo quy định về quản lý AI tạo sinh, trong đó yêu cầu các công ty gửi các đánh giá an ninh cho chính quyền trước khi đưa dịch vụ ra thị trường.