Tống tiền bằng ảnh khỏa thân kiểu mới

Lợi dụng công nghệ deepfake, các đối tượng lừa đảo đang sử dụng chiêu trò ghép mặt nạn nhân vào ảnh khỏa thân nhằm uy hiếp, tống tiền.

|

Vài ngày sau khi John (không phải tên thật) kết nối với một phụ nữ trên ứng dụng hẹn hò OkCupid, anh nhận được tin nhắn từ người bạn.

Người này nói rằng ai đó đã gửi anh ta bức ảnh được cho là hình John khỏa thân.

John (21 tuổi), chia sẻ anh biết đó là người phụ nữ anh gặp trên ứng dụng hẹn hò vào tháng 6 - Janice.

Vài giờ sau, cô tiếp tục gửi cho John bức ảnh chụp khuôn mặt anh trên cơ thể trần trụi của một người đàn ông.

Cô đe dọa sẽ phát tán bức ảnh với nhiều bạn bè khác của anh trên nền tảng mạng xã hội, trừ khi John đồng ý chuyển 1.000 USD vào tài khoản ngân hàng.

Tuy nhiên, John cho hay anh chưa bao giờ gửi cho Janice bức ảnh nào, chứ đừng nói đến ảnh khỏa thân. Họ chỉ có một cuộc trò chuyện qua video.

Kết luận cuối cùng - hình ảnh đó hóa ra là deepfake. Những kẻ lừa đảo đã sử dụng công nghệ trí tuệ nhân tạo (AI) hoán đổi khuôn mặt để ghép khuôn mặt John sang cơ thể khác.

Anh không phải là người duy nhất. Straits Times đã ghi nhận ít nhất 4 người đàn ông bị những kẻ lừa đảo nhắm mục tiêu trong hoạt động “deepfake sexploitation” (tạm dịch: lạm dụng tình dục bằng công nghệ deepfake).

John từ chối đưa tiền cho Janice, nhưng những người khác đã làm. Trong đó có một nạn nhân bị những kẻ lừa đảo tống tiền nhiều lần.

|

| Tài khoản Instagram của kẻ lừa đảo "Janice". Ảnh: Kyleen Cabael. |

Nạn nhân vụ lừa đảo

Hồ sơ trên OkCupid của Janice cho thấy cô cư trú tại Singapore. Tài khoản này tự nhận mình là một cô gái lai Nhật Bản 21 tuổi và rất thích ăn sushi.

“Hồ sơ của cô gái này không có gì khác thường”, John kể lại.

Sau đó khi nối với nhau, anh bắt chuyện cùng Janice thông qua chức năng nhắn tin của ứng dụng. Họ đã trao đổi địa chỉ liên hệ trên Telegram và Instagram.

4 ngày sau, Janice yêu cầu gọi video và John đồng ý.

“Cô ấy trông hơi khác so với ảnh đại diện, nhưng tôi không nghĩ gì về điều đó. Dù vậy, thật kỳ lạ khi cô ấy cứ nhất quyết gọi điện”, anh nói.

“Cô ấy liên tục nói những câu khiêu khích như ‘Tôi muốn làm điều đó ngay bây giờ' cho đến cuối cuộc gọi”, anh kể thêm.

Sau đó, John quyết định họ không hợp nhau và kết thúc cuộc gọi. Vài giờ tiếp theo, anh nhận được tin nhắn từ bạn mình về bức ảnh khỏa thân deepfake. Lời đe dọa của Janice cũng xuất hiện ngay sau đó.

Dù bị sốc nhưng John vẫn phớt lờ lời đe dọa vì anh biết mình không làm gì cả. Anh cũng tìm kiếm lời khuyên trên mạng.

“Tôi học được rằng kẻ lừa đảo thường không thực hiện lời đe dọa vì họ chỉ muốn tống tiền", anh nói.

John nhận thấy Janice đã xóa tài khoản OkCupid trước khi anh tạm dừng tài khoản của mình.

|

| Taylor Swift từng là nạn nhân khi hàng loạt hình ảnh được tạo ra bằng công nghệ deepfake ghép gương mặt của nữ ca sĩ nổi tiếng vào hình ảnh khiêu dâm. Ảnh: Samir Hussein/WireImage. |

Cùng ngày John bị Janice tống tiền, anh nhận được tin nhắn từ bạn mình - Sam (không phải tên thật), cũng 21 tuổi.

Sam muốn hỏi liệu John có biết Janice không, vì anh nhận thấy John theo dõi tài khoản Instagram của cô. Hóa ra Sam cũng là nạn nhân.

Anh gặp Janice trên OkCupid cùng thời điểm với John. Cô ta cũng làm điều tương tự với Sam - trò chuyện trên ứng dụng và sau đó gọi điện video trên Telegram.

Lời đe dọa cũng tương tự, ngoại trừ việc cô muốn anh trả 2.000 USD. Sam lo sợ không ai tin mình nên đã đưa tiền.

Joel (không phải tên thật), 25 tuổi, cũng nhượng bộ. Trong trường hợp của anh, kẻ lừa đảo đã ép anh tổng cộng 2.200 USD, sau khi đòi 700 USD ban đầu.

Vào tháng 8/2023, Joel nhấp vào email lừa đảo mà anh nghĩ rằng đó là phản hồi cho suất học bổng mà anh đăng ký.

Anh được chuyển hướng đến trang web quét khuôn mặt. Vài ngày sau, anh nhận được đoạn video tục tĩu về mình từ người dùng không xác định.

Joel kinh hoàng khi nhận ra đó là video dùng deepfake giả mạo. Kẻ lừa đảo đe dọa sẽ phát tán video tới bạn bè anh trừ khi anh trả 700 USD.

“Tôi sợ hãi vì họ nói rằng có cách thức liên lạc với người thân, bạn bè và đồng nghiệp của tôi. Video trông cũng khá thật”, Joel kể.

Anh đã đưa tiền và cầu xin kẻ lừa đảo xóa video. Thế nhưng, bọn chúng vẫn tiếp tục yêu cầu nhiều tiền hơn. Tổng cộng, Joel trả 2.200 USD cho 3 giao dịch trước khi tìm kiếm sự giúp đỡ.

“Tôi nhận thấy không thể dừng lại được nên đã nói chuyện với anh trai mình. Anh ấy đề nghị tôi báo vụ việc với cảnh sát”, Joel nói.

"Sextortion deepfake"

"Sextortion deepfake" là hiện tượng mới, nhưng nó đã gây chú ý ở nhiều nơi trên thế giới.

Vào tháng 4, một người đàn ông ở Anh đã bị tống tiền bằng đoạn video deepfake làm giả cảnh anh thủ dâm.

|

| Udi Mokady, chủ tịch của CyberArk Software, bên cạnh hình ảnh deepfake của ông. Ảnh: Bloomberg Businessweek. |

Anh nghi ngờ kẻ lừa đảo đã lấy được danh bạ và vào được thư viện ảnh của anh sau khi nhận được cuộc gọi từ số không xác định.

"Khi công chúng nhận thức rõ hơn về công nghệ AI và phần mềm deepfake, việc sử dụng trò lừa đảo deepfake cho âm mưu như tống tiền tình dục có thể gia tăng, đặc biệt ở châu Á”, ông Leonardo Hutabarat - người đứng đầu bộ phận giải pháp kỹ thuật khu vực châu Á - Thái Bình Dương và Nhật Bản tại công ty an ninh mạng LogRhythm - nói.

Một số kẻ lừa đảo đang hoạt động ngoài các trung tâm được thành lập ở Campuchia. Ông Hutabarat cho biết nhiều đối tượng ban đầu bị lừa bởi lời hứa “việc nhẹ lương cao", nhưng sau đó bị ép buộc phải thực hiện hành vi lừa đảo trực tuyến.

Theo ông, vào tháng 4/2024, chính phủ Ấn Độ đã giải cứu 250 công dân khỏi Campuchia. Những người này bị buộc phải làm việc tại các trung tâm và thực hiện hành vi lừa đảo, bao gồm tống tiền tình dục.

“Trò lừa đảo này thường nhắm vào cá nhân đang tìm kiếm mối quan hệ lãng mạn và có thể gây thiệt hại đáng kể cho nạn nhân”, ông nhấn mạnh.

Hutabarat cho biết thêm kẻ lừa đảo cũng sử dụng công cụ deepfake để sao chép giọng nói của bạn bè, thành viên gia đình hay người có thẩm quyền, nhằm đưa ra yêu cầu khẩn cấp về chuyển tiền hoặc thông tin nhạy cảm.

“Âm thanh giả nghe cực kỳ chân thực, khó phát hiện”, ông cho hay.

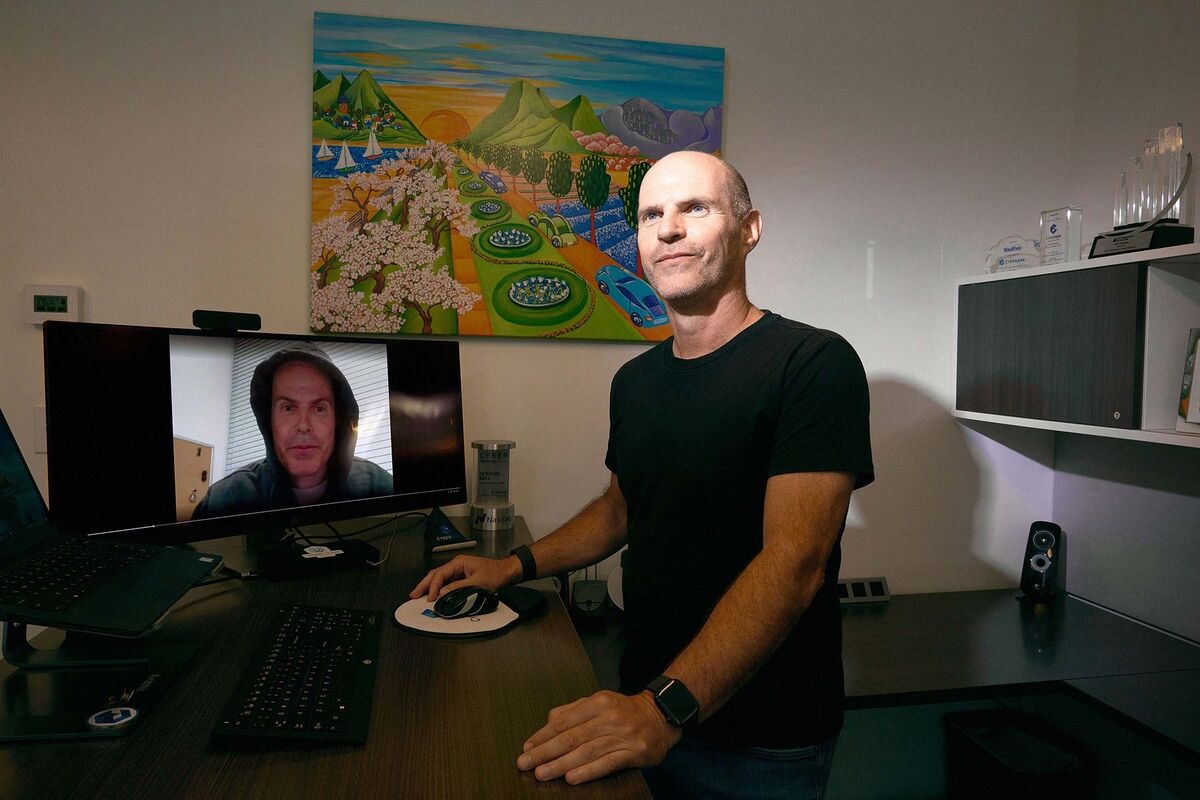

Mối đe dọa trên mạng

Cơ quan An ninh Mạng Singapore (CSA) cho biết sự trỗi dậy và phát triển đáng kể của Generative AI (gen AI) vào năm 2023 có thể giúp tăng năng suất bằng cách tự động hóa nhiệm vụ lặp đi lặp lại và cho phép quá trình sáng tạo hiệu quả hơn.

Tuy nhiên, nó cũng mang đến mối đe dọa mới trên mạng, như khả năng tạo ra video deepfake.

|

| AI mang đến mối đe dọa mới trên mạng. Minh họa: Miel. |

“Khi công cụ và hướng dẫn sử dụng AI ngày càng trở nên phổ biến, bất kỳ ai có hiểu biết về công nghệ ở mức độ vừa phải đều có thể bắt đầu và tạo ra video deepfake trong thời gian tương đối ngắn”, người phát ngôn của cơ quan cho biết.

“Với rào cản đầu vào thấp như vậy, chúng tôi dự kiến thấy sự gia tăng trong việc tạo và sử dụng deepfake, có thể được sử dụng cho nhiều mục đích độc hại khác nhau”.

Theo CSA, vào tháng 2, một nhân viên tài chính tại công ty đa quốc gia ở khu vực châu Á - Thái Bình Dương đã bị lừa chuyển 25 triệu USD. Kẻ lừa đảo sử dụng công nghệ deepfake để đóng vai giám đốc tài chính của công ty trong cuộc gọi hội nghị video.

Ông Hutabarat cho biết một số công ty thậm chí còn cung cấp dịch vụ có tên Deepfakes-as-a-Service, nơi khách hàng có thể nhận được nội dung deepfake chuyên nghiệp với một khoản phí.

Trong bối cảnh đó, CSA khuyên rằng người bị lừa đảo bằng deepfake nên báo cáo cảnh sát và bất cứ tổ chức nào có liên quan.

“Người dùng mạng bị nhắm mục tiêu được khuyên không nên trả tiền cho kẻ lừa đảo, vì trả tiền không đảm bảo rằng chúng sẽ dừng lại”, CSA nói thêm.

Ông Hutabarat nhấn mạnh nạn nhân cần báo cảnh sát để kẻ lừa đảo phải chịu trách nhiệm và không chia sẻ hình ảnh nhạy cảm.

“Việc thu thập bằng chứng rất cần thiết trong bất cứ cuộc điều tra nào. Vì vậy, điều quan trọng là phải ghi giữ lại tất cả thông tin liên lạc, hội thoại và đảm bảo không có phần mềm độc hại nào được cài đặt trên hệ thống của nạn nhân”, ông nói.

AI có cướp đi công việc của chúng ta?

Trong cuốn AI chuyện chưa kể, tác giả Tomoe Ishizumi cho rằng đây chỉ là công cụ tối ưu không hơn không kém. Có một điều chắc chắn rằng AI có thể thay thế phần lớn công việc mà con người đang làm hiện nay. Tuy nhiên, chúng ta không nên nghĩ máy móc sẽ cướp đi công việc của con người mà hãy nghĩ rằng máy móc sẽ làm những công việc vất vả để con người có thời gian sáng tạo hơn.

Link nội dung: https://phunuvathoidaivn.com/tong-tien-bang-anh-khoa-than-kieu-moi-a92176.html